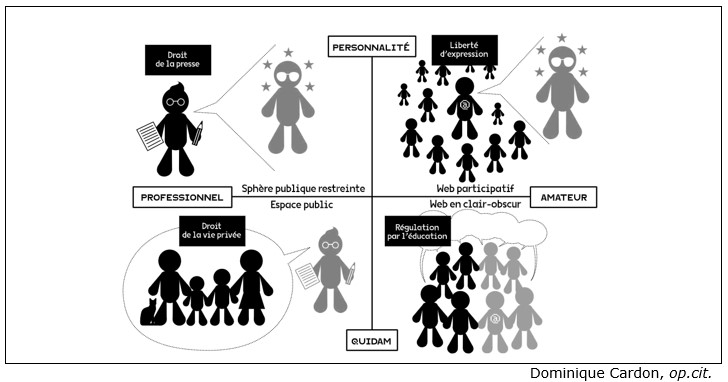

Document texte - Le web n’est pas sans règles et les interventions du législateur y sont même de plus en plus précises et tatillonnes. En prenant un peu de recul, on constate qu’après avoir été indifférentes aux régulateurs, les plateformes ont dû se plier, bon gré mal gré, aux législations nationales. C’est le cas dans le domaine de la propriété intellectuelle où, après les grands conflits des années 2000, les détenteurs de droits ont progressivement obtenu des plateformes qu’elles enlèvent de leurs services les contenus piratés. C’est aussi le cas des droits concernant l’expression en public, qui fait l’objet de limitations et de contrôle. Pour le comprendre, reprenons notre modèle d’espace public et relisons-le avec les lunettes du droit. Les enjeux juridiques sont souvent le reflet d’un conflit entre deux droits opposés. Ici, le droit qui défend la liberté d’expression du locuteur peut s’opposer au droit qui défend la vie privée et l’image de la personne dont on parle. Pour les quatre configurations de prise de parole que nous avons identifiées, le législateur français a créé différents types de compromis entre ces deux droits (…).

Dans la première configuration, celle que nous avons appelée sphère publique restreinte, la tradition législative française privilégie la liberté d’expression du locuteur sur les droits de celui dont il parle. Le droit encourage la liberté d’expression. (…)

Dans la deuxième configuration (espace public), le droit français privilégie à l’inverse la défense de celui qui est l’objet d’une publication offensante portant atteinte à sa tranquillité ou à sa dignité. En France, le droit à l’image et le droit à l’anonymat des personnes mises en examen ont été construits dans cette perspective. (…) L’émergence, depuis 2015, d’un droit européen à l’oubli en est une caractéristique. (…)

Dans la troisième configuration, celle du web participatif, qui voit les utilisateurs déposer des contenus sur toutes sortes de plateformes, un juste équilibre est recherché entre la liberté d’expression de l’internaute (qui parle sans le filtre des gatekeepers) et le droit des personnes dont il parle. La solution juridique qui s’est imposée depuis le début des années 2000 est originale, fragile et légèrement hypocrite. Le législateur, en France comme dans beaucoup de pays, a décidé de séparer la responsabilité juridique de celui qui publie de celle de l’hébergeur (la plateforme de blogs, Facebook, Twitter, Youtube, etc.). L’hébergeur accueille un contenu édité par d’autres. Cette distinction est devenue la colonne vertébrale du droit du numérique. (…) La loi pour la confiance dans l’économie numérique (LCEN) de 2004 a défini pour la France le statut d’hébergeur. Celui-ci n’est plus responsable a priori des contenus qu’il abrite ; seul l’éditeur, celui qui a publié le contenu sur la plate-forme, est considéré comme responsable ; mais, dès lors qu’un contenu illicite, piraté, antisémite, violent est signalé à la plateforme comme contrevenant à la législation, l’hébergeur devient responsable de ce contenu s’il ne se met pas en conformité avec le droit en vigueur dans les États concernés. C’est la raison pour laquelle tous les dispositifs numériques disposent maintenant d’un bouton « signaler ce contenu ». (…) C’est une politique d’extrajudiciarisation qui s’est mise en place, puisque la plateforme doit décider d’elle-même si un contenu signalé est conforme ou non au droit en vigueur, avec le risque que certaines plateformes, par mesure de précaution, surinterprètent le droit et décident de censurer des propos que les tribunaux auraient tolérés.

Dans la quatrième configuration (web en clair-obscur), celle des propos échangés entre les internautes sur les réseaux sociaux, le droit en vigueur s’applique normalement dès lors qu’une plainte est déposée, mais on constate que les troubles produits dans cet espace franchissent rarement la porte des tribunaux. Si l’on tient compte que 34 millions de Français passent 37 minutes par jour sur Facebook, le nombre de plaintes pour harcèlement, cambriolage, diffamation ou usurpation d’identité est singulièrement bas. (…) Cela tient non seulement à une sous-déclaration des litiges, mais aussi à un processus endogène d’autorégulation, de correction mutuelle, de la part de la majorité des participants. (…) C’est donc dans le registre des pratiques, des mœurs et de l’éducation qu’une régulation doit s’établir sur les réseaux sociaux, par l’acquisition d’une bonne compréhension des spécificités du contexte d’énonciation de cet espace mi-privé mi-public que nous avons appelé clair-obscur. (…) À l’évidence, les utilisateurs des réseaux sociaux doivent se montrer toujours plus responsables et vigilants quant à ce qu’ils publient, mais il faudrait aussi interroger le comportement de ceux qui utilisent les informations en les sortant de leur contexte.

Dominique Cardon, op.cit

1. Entre la partie gauche et la partie droite de ce document, quel terme n’est pas repris ?

2. Comment s’établit la régulation des contenus depuis la loi sur la confiance dans l’économie numérique (LCEN) en 2004 ?

3. Quels sont les autres outils dont disposent les plateformes pour modérer les publications ?

4. Quelles sont les tentatives des pouvoirs publics pour dépasser les limites de cette régulation, en France et en Europe ?

Voir la correction

1. Entre la partie gauche et la partie droite de ce document, quel terme n’est pas repris ?

S’agissant de la communication des professionnels comme les journalistes, les éditeurs ou les hébergeurs, le droit s’applique : loi sur la liberté de la presse, le droit à l’image, à l’anonymat ou encore à l’oubli s’imposent.

En revanche, les publications amateurs font l’objet d’une régulation a posteriori qui tient plus de la « solution juridique » que du droit mis en application par un État.

2. Comment s’établit la régulation des contenus depuis la loi sur la confiance dans l’économie numérique (LCEN) en 2004 ?

Afin de ne pas limiter la liberté d’expression, le contrôle des publications s’effectue uniquement a posteriori. Si les hébergeurs tels que Facebook, Twitter ou Youtube ne sont pas tenus responsables des informations diffusées, la LCEN précise leur rôle en cas de faits litigieux.

Si les contenus font l’objet d’un signalement exposant les motifs pour lesquels ils contreviennent à la loi du pays dans lequel ils sont diffusés, les hébergeurs sont alors tenus responsables : après examen, ils doivent supprimer, ou non, ces éléments rapidement.

Ainsi, ce sont bien les grandes sociétés du numérique qui, en dernière instance, agissent et non un tribunal juridique. On parle d’extrajudiciarisation de la démarche de régulation. Il demeure toutefois la possibilité de porter plainte (pour diffamation par exemple) mais celles-ci restent minimes, comparées aux usages.

3. Quels sont les autres outils dont disposent les plateformes pour modérer les publications ?

La plupart des acteurs ont mis en place des « conditions générales d’utilisation » (CGU) indiquant les catégories de contenus acceptées sur le service, et des mécanismes de modération lorsque ces règles ne sont pas respectées par les utilisateurs.

Certains, comme YouTube, ont intégré des volets pédagogiques à destination des utilisateurs de la plateforme sur les comportements proscrits, ou à destination des victimes de comportements agressifs d’autrui. La plateforme a mobilisé des influenceurs pour faire évoluer le comportement des utilisateurs et notamment des plus jeunes d’entre eux. Des rapports de transparence sont publiés par Facebook. En outre, la fonction de modération ne passe pas uniquement par le retrait de contenus considérés comme nocifs, il existe une palette de réponses possibles selon le type de contenu et le degré de dommage potentiel causé par ce contenu (mise en en « quarantaine », cache avec un message de prévention, déréférencement, mise en garde, etc.).

L’ensemble de ces moyens se heurtent cependant aux volumes de publications et présentent toujours un caractère opaque et peu structuré : pour un citoyen comme pour un État, il est impossible de vérifier les démarches mises en œuvre par les plateformes, de faire évoluer les CGU. Chaque média social préserve jalousement la mainmise sur la régulation afin de préserver sa réputation d’espace de libre expression auprès des internautes.

4. Quelles sont les tentatives des pouvoirs publics pour dépasser les limites de cette régulation, en France et en Europe ?

Examiner les informations sur les liens suivants :

· Loi du 24 juin 2020 visant à lutter contre les contenus haineux sur internet, www.vie-publique.fr, 29 juin 2020.

· Martin Untersinger, Alexandre Piquard, « La loi Avia contre la haine en ligne largement retoquée par le Conseil constitutionnel », Le Monde, 18 juin 2020.

· « Réseaux sociaux : un observatoire de la haine en ligne pour analyser les discours haineux », www.vie-publique.fr, 20 octobre 2020.

· Virginie Malingre, « Thierry Breton : ‘Dans bien des cas, l’espace numérique est une zone de non-droit’ », Le Monde, 27 octobre 2020.

· Serge Abiteboul, Jean Cattan, « Nos réseaux sociaux, notre régulation », https://legrandcontinent.eu/fr/2020/04/07/nos-reseaux-sociaux-notre-regulation/, 7 avril 2020.

On a pu le constater en suivant la chronologie funeste qui a précédé l’attentat du 16 octobre 2020 en France, les publications individuelles, rapidement propagées, génèrent des dérives, persistantes malgré les efforts de modération.

Écartés des dispositifs de régulation, les pouvoirs publics en France, mais aussi à l’échelle européenne, tentent de faire évoluer la loi pour obtenir des résultats plus probants.

Outre la LCEN de 2004, la loi Avia[6] a été votée le 25 juin 2020. Elle a cependant été censurée sur de nombreux aspects par le Conseil constitutionnel.

En effet, essentiellement axée sur le renforcement du volet répressif, elle disposait notamment que les réseaux sociaux soient tenus de supprimer en 24 heures tout contenu haineux sauf à supporter de lourdes amendes. Or, cette évolution a été jugée « inadaptée et disproportionnée ». Ces qualificatifs juridiques font référence au fait que les plateformes devaient décider elles-mêmes, sans l’intervention d’un juge compte tenu du délai, du caractère illicite de la publication. Cela augurait donc d’une tendance à la censure excessive de précaution, néfaste à la liberté d’expression.

De cette loi demeure donc aujourd’hui l’observatoire de la haine en ligne qui a été installé en juin 2020.

Il est à noter que l’Europe s’est engagée sur l’économie numérique à travers le Digital Services Act, actuellement en discussion. Ce texte européen, porté par le commissaire européen au marché intérieur Thierry Breton, vise à réguler les contenus publiés sur les plateformes et les plateformes elles-mêmes. Sur le plan des contenus, « ce qui est autorisé off line doit l’être on line, ce qui est interdit off line doit l’être on line », déclare ce dernier. Outre la nécessité de retirer les contenus signalés illicites, il est question de désigner une autorité de surveillance (en France, la CNIL, le CSA ou autre) et de pouvoir identifier les auteurs des publications. Quant aux plateformes, leur poids sur le marché, facteur de blocage aux nouveaux entrants, ferait l’objet d’une attention accrue. Une harmonisation de la règle, commune aux 27 pays de l’Union européenne, aurait ainsi une portée plus forte.

[6] Du nom de la proposition de loi de la députée LREM Laëtitia Avia.